Maîtriser ses informations en ligne est l’une des principales préoccupations aujourd’hui, pour les particuliers comme pour les organisations. 81 % des Européens considèrent que l’amélioration de la cybersécurité, la meilleure protection des données en ligne et la sécurité des technologies numériques sont cruciales.

Mais avec l’IA générative, le partage de données plus ou moins intimes et confidentielles s’intensifie. Cette technologie s’impose partout et sa puissance en ferait presque oublier la destination et l’usage futur des informations transmises. Face aux fuites de données sensibles, au Shadow AI et aux exigences de conformité, les DSI et RSSI doivent désormais s’organiser pour garantir l’efficacité des équipes sans perdre le contrôle de la sécurité.

L’intelligence artificielle s’invite dans vos réunions en ligne

Des assistants virtuels communiquent à votre place

L’essor des technologies d’intelligence artificielle bouleverse les normes établies. Dans les plateformes collaboratives et de visioconférence, l’IA transforme la façon dont nous échangeons, analysons et exploitons le savoir collectif. Peu à peu, elle s’impose comme un indispensable pour être efficace et gagner du temps.

Certains acteurs de visioconférence proposent aujourd’hui des fonctions d’assistant virtuel, basées sur l’intelligence artificielle générative. Intégré dans la solution, l’assistant virtuel peut transcrire, traduire, sous-titrer les échanges d’une réunion en ligne ou encore en faire des résumés textuels synthétiques.

L’objectif ? Améliorer la productivité des utilisateurs en leur facilitant certaines tâches, comme les comptes-rendus de réunions par exemple. Le collaborateur peut se concentrer davantage sur la teneur des échanges pendant que l’IA fait son travail de synthétisation des communications.

.

Comment ça marche ?

Le « large langage model » est généralement utilisé pour agrémenter les visioconférences d’assistant virtuel. Ce modèle d’intelligence artificielle, bien connu par un large public avec Chat GPT, permet de comprendre et de générer du texte, de façon contextuelle et fluide. Ainsi, il est utilisé pour retranscrire textuellement des échanges en visioconférence ou créer des réponses automatiques.

Son entraînement est basé sur une large variété de données. Cela lui permet de comprendre et de produire du langage humain de façon très précise. Plus ce modèle traitera de la donnée, plus il sera performant et apportera de nouvelles réponses.

Pourquoi utiliser l’IA pour ses réunions ?

L’automatisation des tâches chronophages est l’avantage majeur de l’intelligence artificielle pour les réunions en ligne. C’est le cas pour :

- La prise de notes : l’IA peut retranscrire automatiquement l’ensemble de la conversation, utile pour des besoins de traçabilité.

- Le compte-rendu de réunion : l’IA récolte les points clés et les décisions prises durant la discussion et génère des synthèses claires et exploitables dès la fin de la visioconférence.

- La traduction des échanges : L’IA traduit rapidement, parfois même en temps réel, les conversations pour faciliter la collaboration entre des équipes multisites et internationales.

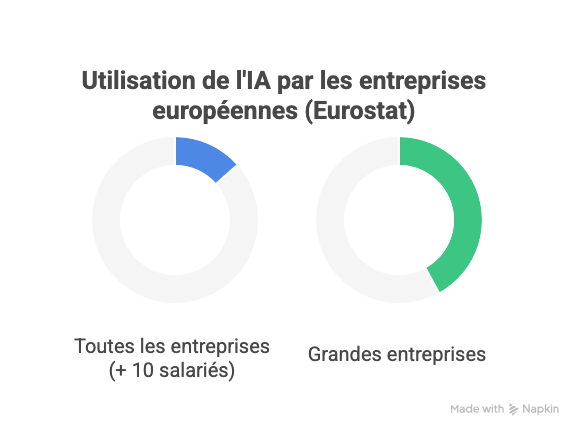

Selon une étude d’Eurostat, 13,5 % des entreprises de l’Union européenne (ayant au moins 10 salariés) utilisent l’intelligence artificielle, soit une hausse de 5,5 points par rapport à 2023. Ce taux atteint 42 % pour les grandes entreprises de plus de 250 salariés.

D’autres intégrations de l’IA permettent d’améliorer le rendu audio et vidéo en visioconférence ou la reconnaissance des émotions. Pour autant, chaque fonctionnalité intelligente ouvre la porte à des risques multiples, souvent insoupçonnés.

Exploiter le potentiel de l’IA dans les visioconférences sans exposer les données devient alors un véritable défi.

Deux risques majeurs

Vulnérabilités et failles de sécurité

Dans les outils de collaboration et de visioconférence traditionnels, les modules d’IA génératives intégrés sont généralement connectés à Internet et gardent en mémoire les informations renseignées par les utilisateurs.

En mars 2025, une faille critique baptisée « EchoLeak » (CVE-2025-32711) dans le plugin IA Copilot, intégré à Microsoft 365, a permis une attaque zero click. Un simple e-mail a pu déclencher, sans aucune action de l’utilisateur, l’exfiltration automatique de données sensibles accessibles par Copilot (chats, documents, SharePoint, Teams…). En injectant des instructions frauduleuses à distance, les cyberattaquants ont voulu exploiter la mémoire contextuelle riche du plugin et exfiltrer des données sensibles. L’utilisateur n’a jamais interagi avec le contenu piégé.

Cela démontre que l’IA est capable d’exécuter aveuglément des prompts et que la mémorisation des informations peut, dans ce type d’attaques, représenter un risque majeur de fuite de données.

Shadow AI

À l’image du shadow IT, phénomène consistant à utiliser des logiciels et applications informatiques non approuvés par la DSI, le shadow AI fait partie des dangers émergents au sein des entreprises. Cette pratique, qui consiste à utiliser des IA génératives gratuites, non vérifiées en interne, crée d’importantes vulnérabilités. De nombreux collaborateurs sont amenés à y copier-coller des informations sensibles, parfois issues de réunions, pour générer des rapports, des présentations ou des traductions.

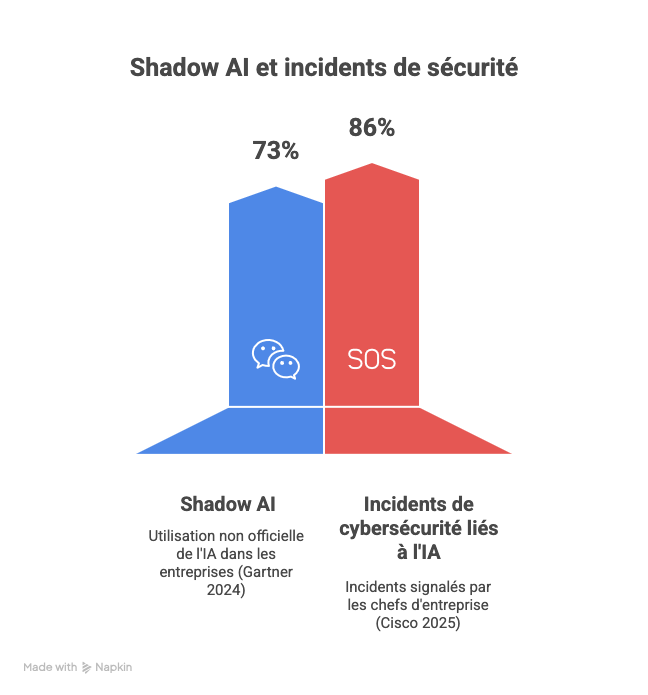

Dans une étude Gartner en 2024, 73 % des entreprises déclarent que l’IA générative est utilisée en dehors des processus IT officiels (“shadow AI”), principalement via des outils comme ChatGPT, Copilot, ou Gemini.

Par ailleurs, près de neuf chefs d’entreprise sur dix (86 %) ayant des responsabilités en matière de cybersécurité ont signalé au moins un incident lié à l’IA au cours des 12 derniers mois selon le Cisco Cybersecurity Readiness Index 2025.

Ce phénomène de Shadow AI échappe en bonne partie à la surveillance des DSI et RSSI et expose les données stratégiques à de nombreuses menaces :

- Stockage des données hors UE, sans garantir la conformité au RGPD,

- Vulnérabilités aux attaques externes non détectées,

- Multiplication des accès et partage non contrôlés.

Le recours à des applications IA non sécurisées, en complément de la visioconférence, contribue également à multiplier les vecteurs d’attaque.

De plus, lorsque ces outils sont extra-européens, l’organisation a peu de visibilité sur la gestion des données, la sécurité des modèles et la conformité aux standards européens.

Avec l’IA Act appliquée au sein de l’UE, des normes strictes de sécurité, de transparence et de gestion des risques doivent être respectées pour utiliser l’IA. Toutes les organisations, et surtout les plus sensibles, sont concernées.

Bonnes pratiques pour utiliser l’IA dans les visioconférences

Pour les organisations évoluant dans des secteurs sensibles (défense, industries, finance…) et répondant à des réglementations strictes comme NIS 2 ou DORA, la vigilance face à l’IA doit être renforcée. Voici quelques bonnes pratiques.

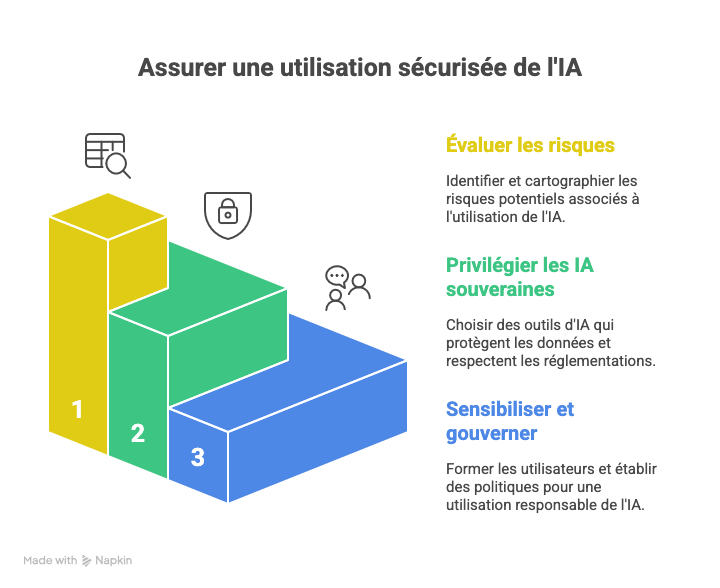

Évaluer les risques

Avant d’utiliser un assistant IA, il est essentiel de mener une analyse de risques spécifique.

Cette analyse doit permettre :

- De cartographier les flux de données sensibles

- Et d’identifier les scénarios de menaces, tels que l’injection de prompts malveillants ou les fuites via des plugins tiers.

Les procédures de gestion de crise, notamment le plan de continuité d’activité (PCA) et le plan de reprise d’activité (PRA), doivent également être mises à jour pour prendre en compte les éventuelles défaillances de l’IA.

Privilégier les IA sécurisées et souveraines

L’utilisation d’outils d’IA générative grand public, non sécurisés et non validés par la DSI, accroît le risque de fuite de données, d’autant plus pour les échanges professionnels. Dans certaines plateformes de collaboration, les assistants d’IA intégrés enregistrent les conversations et les prompts et peuvent s’entraîner sur ces données. Il est plutôt recommandé d’utiliser une IA hébergée en Europe, soumise à l’IA Act, qui protège les données.

Sensibiliser et gouverner l’usage de l’IA

Une politique interne d’utilisation de l’IA doit être rédigée et intégrée au référentiel sécurité de l’organisation. Elle comprend :

- Les usages permis ou interdits,

- Les procédures de validation des outils,

- Le reporting des usages non contrôlés (Shadow AI).

La formation régulière des utilisateurs, dirigeants et managers est indispensable pour comprendre les risques liés à l’IA, appliquer les bonnes pratiques de confidentialité et gérer correctement les invitations et le partage en réunion.

Enfin, la mise en place d’une gouvernance commune entre la DSI, le RSSI et les directions métiers permet de concilier innovation et sécurité, tout en clarifiant les responsabilités et décisions pour tout nouveau besoin IA.

L’IA dans la collaboration en ligne n’est plus une option : c’est aujourd’hui devenu incontournable pour gagner en productivité. Les organisations qui n’exploitent pas encore ces outils prennent du retard. Même les secteurs les plus contraints en matière de cybersécurité franchissent le pas, en veillant bien sûr à protéger leurs données confidentielles.

Certification CSPN ANSSI

Depuis plus de 8 ans, Tixeo a obtenu à trois reprises le renouvellement de sa certification CSPN de l’ANSSI, gage de sa fiabilité et son engagement pour la cybersécurité. Découvrez son approche Secure By Design et sa technologie de chiffrement de bout en bout.